Argonautów, płynących z Kolchidy ze złotym runem, zaatakował na Krecie Talos, mechaniczny olbrzym ze spiżu. Patrolował wybrzeże wyspy, obiegając ją trzykrotnie w ciągu dnia i rzucając głazami w statki, które nieopatrznie zbliżyły się do brzegu. Medei udało się go zaczarować i śpiącemu przecięto życiodajną „żyłę”. Z Talosa uszła energia i padł martwy. Czy był automatem napędzanym parą, jak chcą niektórzy? Czy mit o spiżowym człowieku to niejasne wspomnienie starożytnych dokonań w dziedzinie robotyki?

Talos był dziełem greckiego boga-konstruktora, Hefajstosa. W późniejszych wiekach już nie boscy, lecz ludzcy konstruktorzy starali się go naśladować, ale tak naprawdę czas automatów nadszedł dopiero w drugiej połowie XX w., po zbudowaniu w 1971 r. pierwszego mikroprocesora. Układ scalony o nazwie 4004 składał się z 2300 tranzystorów i wykonywał 60 tys. operacji na sekundę. Dziś wydaje się to niczym, lecz wówczas było to niezwykłe osiągnięcie. Warto przypomnieć, że podobną moc obliczeniową miał ogromny ENIAC – komputer lampowy zbudowany w latach 40. XX w. Co więcej, ENIAC liczył trzydziestokrotnie wolniej od miniaturowego 4004. Entuzjastom wydawało się, że już wkrótce uda się skonstruować „sztucznego człowieka”, czyli maszynę, o której w swoim dramacie z 1920 r., pod tytułem „R.U.R.”, pisał czeski autor, Karel Čapek, nadając mu nazwę „robot”. Określenie to zrobiło zawrotną karierę, stając się jedynym chyba słowem z języka słowiańskiego, które na stałe weszło do języka potocznego na całym świecie.

Niestety, okazało się, że to nie takie proste. Konstruktorzy szybko przekonali się, jak trudne jest naśladowanie funkcji żywego organizmu, a co dopiero mówić o zbudowaniu czegoś doskonalszego. Warto przypomnieć, że za jedno z największych osiągnięć w robotyce uznano skonstruowanie przez Japończyków robota, który potrafił… wchodzić po schodach. Czynność ta, tak prosta dla ludzi, jest w rzeczywistości niezwykle skomplikowana. Dotyczy to zresztą niemal wszystkich naszych umiejętności.

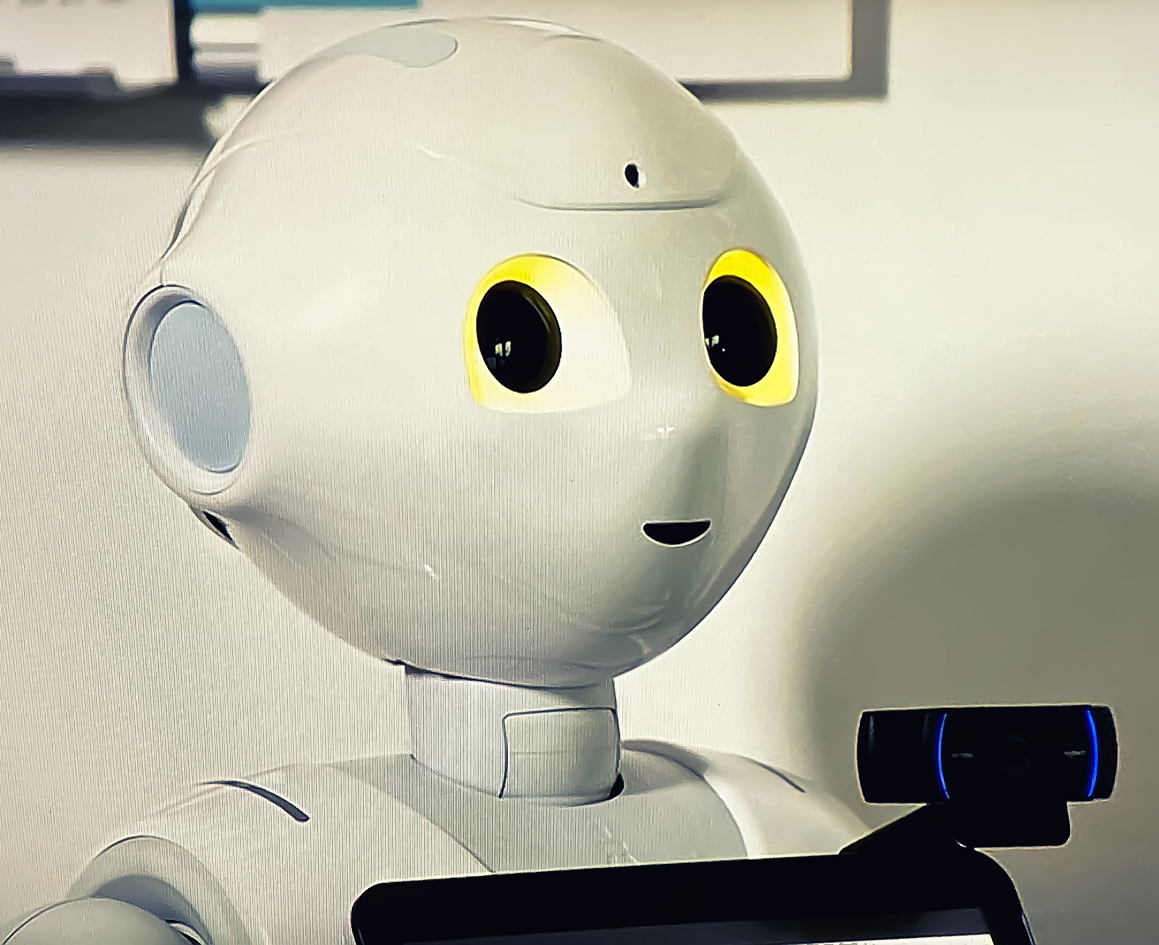

Określenie „roboty” jest na tyle pojemne, że obejmujemy nim tak różne urządzenia, jak automaty w fabrykach, zdalnie sterowane roboty chirurgiczne czy autonomiczne odkurzacze w domach. Lecz tak naprawdę, kiedy myślimy o robotach, widzimy w wyobraźni urządzenia w rodzaju sympatycznych sztucznych bohaterów „Gwiezdnych wojen”: małego R2D2 i gadatliwego C3PO. One też doskonale ilustrują dwie rywalizujące ze sobą tendencje w robotyce.

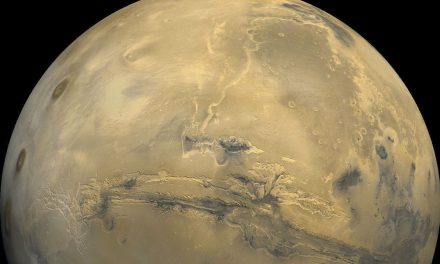

Pierwsza – to konstruowanie robotów niepodobnych do ludzi. Istnieje tu ogromne pole do popisu i takie roboty mogą się od siebie diametralnie różnić. Ich wygląd i możliwości mają być dostosowane do rodzaju wykonywanej pracy. Nie brak ich dzisiaj w fabrykach i zakładach produkcyjnych, ale są też ciekawsze przykłady. Dzięki takim urządzeniom odbywa się bowiem dziś podbój kosmosu. Pierwszym robotem na Marsie był Sojourner – niewielki, sześciokołowy pojazd, dostarczony tam w 1997 r. przez sondę Pathfinder. Łazik został wyposażony w system autonomicznego podejmowania decyzji, dzięki czemu mógł – bez oczekiwania na komendy z Ziemi – poruszać się i omijać przeszkody. Ponieważ opóźnienie sygnału radiowego między Marsem a naszą planetą wynosi ok. 10 min., sterowanie łazikiem w czasie rzeczywistym nie wchodziło w grę. Był więc – by tak rzec – w swoich decyzjach niezawisły. Jego sprawność nie była jednak najlepsza. Ilość danych, które musiał przetworzyć dla podjęcia „decyzji”, była tak wielka, że mógł poruszać się z prędkością nie większą niż kilka metrów na godzinę.

Kolejnymi tego typu robotami na Marsie były Opportunity (wylądował na Marsie w 2004 r., a zakończył pracę w 2019 r.) i Curiosity, który od 2011 r. do dziś jeździ po powierzchni Czerwonej Planety.

Za pierwszego robota domowego można uznać urządzenie o nazwie Big Trak z lat 80. XX w., jednak jest to określenie mocno na wyrost. Był to bowiem raczej wózek kołowy przewożący niewielkie ładunki między pomieszczeniami, i to po z góry zaprogramowanych trasach. Obecnie częstym widokiem są już „inteligentne” roboty-odkurzacze. Są już w pełni autonomiczne. Taki odkurzacz sam zapoznaje się z otoczeniem, omija przeszkody, a nawet decyduje, kiedy należy zaparkować na specjalnej bazie celem naładowania akumulatora.

Znacznie bardziej dla nas interesujący jest drugi nurt w robotyce, a mianowicie budowa androidów – robotów ukształtowanych na nasz obraz i podobieństwo. Punktem wyjścia dla entuzjastów tego trendu jest przekonanie, iż należy naśladować najbardziej uniwersalne urządzenie, jakie stworzyła ewolucja – ludzkie ciało.

Jednak ciało to nie wszystko. Dzisiejsze roboty potrafią już dość dobrze imitować ruchy i gesty człowieka. Ale co z mózgiem, w który powinien być wyposażony android? Tu zaczynają się – nomen omen – schody.

Ludzki mózg to ciągle niedościgniony wzór dla twórców sztucznej inteligencji. Trudno naśladować jego pracę, skoro wciąż nie rozumiemy, jak funkcjonuje. Pewną nadzieję dają tzw. sieci neuronowe. Jak wiadomo, człowiek uczy się całe życie, co oznacza, że mózg jest zdolny do nabywania wiedzy i zdolności w oparciu o rozmaite bodźce. Współczesne komputery tego nie potrafią; umieją tylko przetwarzać dostarczone im dane. Są tak naprawdę jedynie skomplikowanymi liczydłami. Na innej jednak zasadzie działają systemy uczące się, takie jak sztuczne sieci neuronowe. W oparciu o informacje zawarte w pamięci komputera potrafią wyciągać logiczne wnioski i konkluzje, których wprost w pamięci nie zapisano. Jest to więc swego rodzaju „myślenie”.

Tym bardziej, że sieci neuronowe uczą się, poprzez analizę wielkich ilości danych. Im więcej danych, tym uczenie się jest skuteczniejsze, a odpowiedzi takiej sztucznej inteligencji na zadawane pytania – rozsądniejsze.

O skuteczności takiego naśladowania ludzkiej inteligencji świadczy powszechne już dziś stosowanie sztucznej inteligencji w kontaktach z ludźmi. Można się z nimi zetknąć choćby na infoliniach firm telekomunikacyjnych; nie mówiąc już o popularnych asystentach w smartfonach, typu Asystenta Google, Siri czy Bixby, z którymi można nawet porozmawiać.

Czyżbyśmy zatem spełnili już warunek Turinga? W 1950 r., w artykule w miesięczniku „Mind”, Alan Turing zaproponował test na stwierdzenie, czy dana maszyna myśli. Test jest niezwykle prosty: jeśli porozmawiasz z czymś i nie zorientujesz się, że to nie jest człowiek, to znaczy, że jest to coś, co myśli. Na odtrąbienie sukcesu jest chyba jeszcze za wcześnie, ale postęp jest niebywały.

Skoro mózg człowieka to ciągle zbyt wielkie wyzwanie, może należy zacząć od mózgów zwierząt? Na taki pomysł już w latach 90. ubiegłego wieku wpadli Japończycy. Uznali, że pierwszym myślącym robotem ma być kot – Robokoneko (robo od robota i koneko – po japońsku kotek). Prace nad konstrukcją sztucznego kota wiele wniosły do rozwoju robotyki, lecz, jak wiadomo, myślący kot-robot wciąż nie powstał i prawdopodobnie nie powstanie w najbliższej przyszłości.

Za trzeci z najważniejszych nurtów w cybernetyce można uznać cyborgizację, a więc połączenie naturalnego ze sztucznym bądź – ujmując to inaczej – żywego z martwym. Cyborgiem może być zarówno człowiek, jak i zwierzę, u którego zastąpiono część organów czy narządów ich sztucznymi odpowiednikami. Oczywiście, pojawia się pytanie o stopień cyborgizacji. Teoretycznie można byłoby wymienić sobie wszystko z wyjątkiem mózgu, aby pozostać sobą, i być może wiele osób sparaliżowanych skorzystałoby z takiego rozwiązania. Większości z nas zapewne wystarczyłyby drobniejsze modyfikacje: mechaniczne ramiona itp. Technicznie nie jest to już niemożliwe, należy więc przypuszczać, że o rozwoju cyborgizacji zadecydują czynniki społeczno-psychologiczne, a także religijne – problem dopuszczalności i stopnia ingerencji w ludzkie ciało, koszty, a nawet… moda. A może moda przede wszystkim. Pisał już zresztą o tym niejednokrotnie – dowcipnie i trafnie – w swoich wizjonerskich opowieściach Stanisław Lem.

Początek został zrobiony. Pierwszym człowiekiem, który wszczepił sobie pod skórę mikroczip, był Kevin Warwick, wykładowca na wydziale cybernetyki Uniwersytetu Reading w Wielkiej Brytanii. Począwszy od roku 1999 przez kilka miesięcy używał go do logowania się do sieci komputerowej w swoim laboratorium. Najbardziej spektakularnym efektem owej „cyborgizacji” było zapalające się w laboratorium światło, kiedy tylko prof. Warwick wszedł do środka. Zasłużył sobie tym na miano „pierwszego cyborga”.

Współczesne roboty są wąsko wyspecjalizowane, co czynie je bezradnymi w sytuacjach wykraczających poza ich program. Z kolei roboty uniwersalne – nie dość, że trudne do zbudowania i zapewne drogie – nie spełniłyby raczej pokładanych w nich oczekiwań, zgodnie z powiedzeniem, że jeśli coś jest do wszystkiego, to jest do niczego. Wyjściem z tego dylematu może być ewolucja robotów. Odbywałaby się ona w pamięci komputera, na etapie projektowania robota potrzebnego do wykonania określonych zadań. Kolejne cyfrowe „pokolenia” maszyn rodziłyby się i umierały, każde wyposażone w inne cechy, aż do momentu, kiedy zestaw tych cech gwarantowałby spełnienie oczekiwań.

Także i tutaj prekursorem był Stanisław Lem. W znakomitej mikropowieści „Niezwyciężony” opisał ewolucję maszyn – walkę o byt (czyli o źródła energii) robotów pozostawionych na pustynnej planecie. Wygrały nie te największe, wyposażone w najpotężniejszą broń czy najsprawniejsze mózgi, lecz małe, bezrozumne „owady”, których przewaga polegała na tym, że potrafiły łączyć się w „chmury” dostosowujące swoją wielkość i siłę do wyzwania, jakiemu musiały sprostać.